Metoder för AI-forskning och utveckling

Vetenskap / AI & robotik / Allt om AI

Det finns ingen etablerad sammanhållande teori eller paradigm som styr AI-forskning. Forskare är oense om många frågor. Några av de mindre viktiga frågorna som har förblivit obesvarade är följande: Bör AI simulera naturlig intelligens genom att studera psykologi eller neurologi? Eller är människans biologi lika irrelevant för AI-forskning som fågelns biologi är för flygteknik? Kan intelligent beteende beskrivas genom att använda sig av enkla, eleganta principer (som logik eller optimering)? Eller behöver man lösa stora mängder av helt orelaterade problem? Kan intelligens reproduceras genom att använda symboler på hög nivå, precis som med ord eller idéer? Eller behöver den undersymbolisk behandling? John Haugeland som myntande begreppet GOFAI (Good old fashioned AI = god gammalmodig artificiell intelligens), föreslog att AI borde kallas för syntetisk intelligens, ett begrepp som sedan antogs av flera icke-GOFAI forskare.

Cybernetik och hjärnsimulering AI

På 1940- och 1950-talen utforskade ett antal forskare sambandet mellan neurologi, informationsteori, och cybernetik. En del av dessa byggde maskiner som använder sig av elektroniska nätverk för att uppvisa rudimentärt intelligens, såsom W. Grey Walters sköldpaddor och Johns Hopkins Odjur. Många av dessa forskare samlades för möten vis Teologiska Samfundet vid Princeton Universitet och Ratio Klubben i England. År 1960 var detta tillvägagångssätt i stort sett övergiven, även om delar av den skulle återuppstå under 1980-talet.

Symbolik och AI

När tillgång till digitala datorer blev möjlig i mitten av 1950-talen, började AI-forskare undersöka om mänsklig intelligens kunde reduceras till symbol manipulation. Den här forskningen centrerades i tre olika institutioner: CMU, Stanford och MIT, och var och en av dessa utvecklade dess egen forskningsstil. John Haugeland kallade dessa metoder för AI-utveckling “de goda gammalmodiga AI” eller GOFAI, (”Good old fashioned AI”). Under 1960-talen, uppnådde symboliska metoder framgång i simulering av högre tänkande i mindre demonstrativa program. Metoder som baserades på cybernetik eller neurala nätverk gavs upp eller trycktes undan i bakgrunden. Forskare var övertygade under 1960- och 1970-talen att symboliska metoder eventuellt skulle skapa machiner med Generell AI och det var vart deras jobb hade som syfte.

När tillgång till digitala datorer blev möjlig i mitten av 1950-talen, började AI-forskare undersöka om mänsklig intelligens kunde reduceras till symbol manipulation. Den här forskningen centrerades i tre olika institutioner: CMU, Stanford och MIT, och var och en av dessa utvecklade dess egen forskningsstil. John Haugeland kallade dessa metoder för AI-utveckling “de goda gammalmodiga AI” eller GOFAI, (”Good old fashioned AI”). Under 1960-talen, uppnådde symboliska metoder framgång i simulering av högre tänkande i mindre demonstrativa program. Metoder som baserades på cybernetik eller neurala nätverk gavs upp eller trycktes undan i bakgrunden. Forskare var övertygade under 1960- och 1970-talen att symboliska metoder eventuellt skulle skapa machiner med Generell AI och det var vart deras jobb hade som syfte.

Kognitiv simulering AI

Bild: Herbert Simon och Allen Newell

Ekonomisten Herbert Simon och Allen Newell studerade mänsklig skicklighet som avsåg problemlösning och försökte formalisera dem. Deras jobb lade fram grunden till AI-forskningsfältet och till kognition vetenskapen, operationsforskning och styrningsvetenskapen. Forskarna gjorde bruk av resultaten som kom från psykologiska experiment för att utveckla program som simulerade de metoder och tekniker som människor använde sig av när de löste olika problem. Den här forskningstraditionen som centrerades vid Carnegie Mellon University kom så småningom att kulminera i utvecklingen av ¨den så kallade ”Soar arkitekturen” i mitten av 1980-talen.

Logikbaserad AI

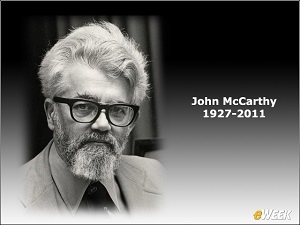

Till skillnad från Newell och Simon, ansåg John McCarthy att maskiner inte behövde simulera mänsklig tankeförmåga, utan att de istället skulle försöka finna essensen i abstrakta resonemang och problemlösning, oavsett om människor använde samma algorytmer eller inte. Labbet vis Stanford (SAIL) fokuserade på att använda sig av formell logik för att lösa en bred varietet av problem, och dessa innefattade kunskapsrepresentation, planering och inlärning. AI – forskning som fokuserade på logik tog plats även vid Edinburgh Universitet och på andra platser i Europa något som ledde till utvecklingen av programmeringsspråket Prolog och den logiska programmeringsvetenskapen.

”Anti-logik” eller ”sjaskig” AI

Forskare vid MIT (såsom Marvin Minsky och Seymour Papert), fann att lösning av svåra problem i vision och naturlig språkbehandling krävde ad-hoc lösningar. De hävdade att det inte fanns några enkla och generella principer (såsom logik) som kunde fånga alla aspekter av intelligent beteende. Roger Schank kallade deras ”anti-logik” metoder ”sjaskiga”. Sunt-förnuft kunskapsbaser (såsom Doug Lenats Cyc) är exempel på sjaskig AI eftersom de måste byggas upp för hand, ett komplicerat begrepp för sig.

Kunskapsbaserad AI

När datorer med stort minne blev tillgängliga på 1970-talen, började forskare från alla tre traditionerna bygga upp kunskap in i AI-program. Den här ”kunskapsrevolutionen” ledde till utvecklingen och användningen av ”expert system” (som introducerades av Edward Feigenbaum), den första verkligen framgångsrika formen av AI-mjukvara. Kunskapsrevolutionen drevs dessutom av insikten att en stor mängd kunskap behövdes av många enkla AI-applikationer.

Under-symbolisk AI

Under 1980-talen verkade framstegen inom symbolisk AI att stanna av och många trodde att symboliska system inte någonsin kunde härma alla processer som äger rum i mänsklig kognition, i synnerhet perception, robotik, inlärning och mönsterigenkänning. Några forskare började titta in i ”sub-symboliska” metoder för att lösa specifika AI-problem.

Bottom-up, förkroppsligad, belägen, beteende-baserad eller nouvelle AI

Forskare från det relaterade robotik området, såsom Rodney Brooks, avvisade symboliskt AI och fokuserade på de grundläggande tekniska problem som skulle tillåta robotar att röra på sig och överleva. Deras forskning och arbete återupplivade det icke-symboliska perspektivet hos 50-talets forskare inom cybernetik och återintroducerade användningen av kontrollteorin inom AI-forskning. Detta sammanföll med utvecklingen av den förkroppsligade sinnet-teorin inom kognitionsvetenskap, d.v.s. idén att vissa kroppsliga aspekter, såsom rörelseförmåga, perception och visualisering, kvävs för högre intelligens.

Datorintelligens (Computational intelligence)

Intresset för neurala nätverk och ”konnektionism” (sammankoppling), återupplivades av David Rumelhart bland andra i mitten av 1980-talen. Dessa och andra sub-symboliska metoder, såsom luddiga system och evolutionär datavetenskap, studeras nu av disciplinen som sedan utvecklades och som kallas för datorintelligens.

Intresset för neurala nätverk och ”konnektionism” (sammankoppling), återupplivades av David Rumelhart bland andra i mitten av 1980-talen. Dessa och andra sub-symboliska metoder, såsom luddiga system och evolutionär datavetenskap, studeras nu av disciplinen som sedan utvecklades och som kallas för datorintelligens.

Statistiskt AI

Under 1990-talen utvecklade AI-forskare sofistikerade matematiska verktyg för att lösa specifika underproblem. Dessa verktyg är verkligen vetenskapliga, i den meningen att deras resultat kan mätas och verifieras, och de har lett till många av AI-framgångarna. Det delade matematiska språket har gjort samarbete mellan etablerade fält möjlig (bland annat mellan matematik, ekonomi och operationsanalys). Stuart Russell och Peter Norvig kallar den här rörelsen för en ”revolution”. Kritikerna hävdar däremot att de här teknikerna är alltför fokuserade på särskilda problem i stället för att fokusera på den generella intelligensens långsiktiga mål.

Integrering av metoderna

Det intelligenta agent-paradigmet

Intelligenta agenter är system som uppfattar miljön och handlar på ett sätt som maximerar chansen för framgång. De enklaste intelligenta agenterna är program som löser specifika problem. Mera komplicerade agenter innefattar människor och organisationer som består av människor (såsom företag).

Paradigmet ger forskare rätten att studera isolerade problem och finna lösningar som är både verifieringsbara och användbara, utan att behöva komma överens om en enda metod. En agent som löser ett specifikt problem kan använda sig av många olika metoder som fungerar. Vissa agenter är symboliska och logiska, andra är under-symboliska neurala nätverk och andra kan använda sig av nya metoder. Paradigmet ger dessutom forskarna ett gemensamt språk för att kommunicera med andra fält – såsom beslut teori och ekonomi - som också använder sig av koncept om abstrakta agenter. Det intelligenta agent paradigmet blev allmänt accepterat under 1990-talen.

Agent arkitekturer och kognitiva arkitekturer

Forskare har nyutvecklat system som kan bygga upp intelligenta system utav intelligenta agenter som interagerar med varandra i ett multi-agent system. Ett system med både symboliska och under-symboliska beståndsdelar är hybrida intelligenta system. Studien av sådana system kallas för Artificiell Intelligens System Integration. Hierarkiska kontrollsystem förser med en bro mellan undersymbolisk AI, reaktiva nivåer och traditionella symboliska AI-system. Avslappnade tidsintervaller tillåter planering och världsmodellering.

Källa: Arficial Intelligence